WindowsO Windows é hoje um conglomerado de versões de sistemas operacionais já lançados pela

Microsoft, responsáveis por gerir e executar processos em computadores pessoais e empresariais de todo o mundo.

Com o início do desenvolvimento em 1981 pela Microsoft, capitaneada pelos jovens Bill Gates e Paul Allen, esse sistema operacional foi apresentado na versão primária com uma interface gráfica bidimensional para o MS-DOS; sendo responsável, junto com o Mac, por intermediar e facilitar a utilização de computadores pessoais por usuários não especializados no segmento de computação, que obtiveram inúmeras vantagens com esse novo modo de utilizar um PC.

Enquanto entregava funcionalidades úteis a eles, o Windows oferecia também recursos para entretenimento, como jogos e players de mídia, que foram ganhando espaço a cada ano, e novas tecnologias, tornando-se cada vez mais uma central de trabalho vinculada a outra, com perfil de entretenimento.

Criado em linguagem C, e porções em C++ e Assembly, usuários mais antigos do Windows se lembrarão da época em que esse sistema operacional era comercializado em disquetes, havendo um longo processo e sequenciamento deles para instalar o SO completamente em uma máquina. Com as atualizações do Windows, formas facilitadoras, foram surgindo - como a utilização de um único disco “bootavel” para inicialização, formatação e instalação - programas que dispensavam a instalação de drivers a partir de disquetes ou CDs, buscando-os online, e hoje em dia, interface de uso que dialoga com telas touchscreen, a exemplo dos Windows 8 e 8.1.

Com versões que contavam com boa aceitação pelo mercado, como o Windows XP, e outras que não foram tão bem recebidas, a exemplo do Vista, o Windows tornou-se rapidamente o núcleo de computação de muitos usuários, que vão desde pessoas interessadas somente em checar e-mails e informações online, até programadores, cientista, escritores e outros. Aliado a isso, a Microsoft ainda implementou uma série de novos produtos, como a suíte de escritório Microsoft Office, fortalecendo-se ainda mais no segmento de tecnologia.

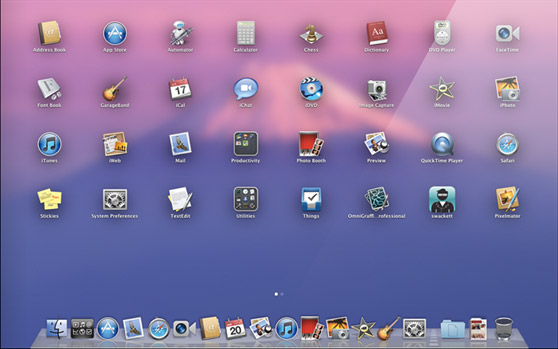

Mesmo havendo muitos outros sistemas operacionais no mercado, como o Mac OS X e as diversas distribuições para Linux, o Windows ainda é o sistema mais utilizado no mundo, tanto por usuários caseiros quanto empresas e servidores.